Pesquisas mostram como o uso de um sistema aprimorado por IA pode afetar a percepção humana de sua própria intuição e responsabilidade.

À medida que a inteligência artificial desempenha um papel cada vez maior em sistemas automatizados e processos de tomada de decisão, a questão de como ela afeta o senso de agência das pessoas está se tornando menos teórica e mais urgente.

O senso de agência do usuário refere-se à percepção que um indivíduo tem de ser o autor de suas próprias ações e decisões. Em outras palavras, é o sentimento de controle e responsabilidade que uma pessoa tem sobre suas próprias ações e os resultados dessas ações. Esse senso de agência é crucial para a autonomia e para a tomada de decisões informadas.

Não é surpresa que os humanos frequentemente sigam as recomendações de decisão automatizadas, com incentivos para “confiar na IA!” estimulando a adoção do usuário em ambientes corporativos. No entanto, há evidências crescentes de que a IA diminui o senso de responsabilidade dos usuários pelas consequências dessas decisões.

Essa questão é amplamente ignorada nas discussões atuais sobre IA responsável. Na realidade, essas práticas destinam-se a gerenciar riscos legais e de reputação — uma visão limitada de responsabilidade, se recorrermos à útil conceitualização do filósofo alemão Hans Jonas. Ele definiu três tipos de responsabilidade, mas a prática da IA parece se preocupar apenas com duas. A primeira é a responsabilidade legal, onde um indivíduo ou entidade corporativa é responsável por reparar danos ou compensar perdas, normalmente via direito civil; a segunda é a responsabilidade moral, onde os indivíduos são responsabilizados por meio de punições, como no direito penal.

O que mais nos preocupa aqui é o terceiro tipo, o que Jonas chamou de senso de responsabilidade. É o que queremos dizer quando falamos admiravelmente de alguém “agindo de forma responsável”. Envolve pensamento crítico e reflexão preditiva sobre o propósito e possíveis consequências das ações, não apenas para si mesmo, mas também para os outros. É esse senso de responsabilidade que a IA e os sistemas automatizados podem alterar.

Para obter insights sobre como a IA afeta as percepções dos usuários sobre sua própria responsabilidade e senso agência (o que o torna um agente de suas ações), conduzimos vários estudos. Dois estudos examinaram o que influencia a decisão de um motorista de retomar o controle de um veículo autônomo quando o sistema de direção autônoma está ativado.

No primeiro estudo, descobrimos que quanto mais as pessoas confiam no sistema autônomo, menos provável é que mantenham a consciência situacional que lhes permitiria retomar o controle do veículo em caso de problema ou incidente. Embora os respondentes, em geral, tenham afirmado aceitar a responsabilidade ao operar um veículo autônomo, seu senso de agência não teve influência significativa em sua intenção de retomar o controle do veículo em caso de problema ou incidente. Com base nesses achados, podemos esperar encontrar que uma proporção considerável de usuários se sinta encorajada, na presença de um sistema automatizado, a evitar a responsabilidade de intervir.

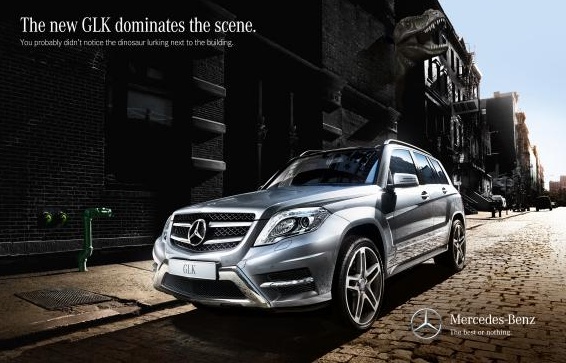

No segundo estudo, conduzido com a Société de l’Assurance Automobile du Québec, uma agência governamental que administra o programa público de seguro automóvel da província, fomos capazes de conduzir análises mais refinadas. Pesquisamos 1.897 motoristas (principalmente de carros Tesla e Mercedes com algum nível de capacidade de direção autônoma) para analisar separadamente o efeito de cada tipo de responsabilidade na intenção do motorista de retomar o controle do veículo e descobrimos que apenas o senso de responsabilidade teve um efeito significativo.

Como no primeiro estudo, quanto mais confiança os respondentes relataram ter no sistema automatizado, menor foi sua intenção de retomar o controle ao volante. É particularmente notável que apenas o senso de responsabilidade proativo e individual motivou os respondentes a agir, o que indica que a ameaça de responsabilidade será insuficiente para evitar danos causados pela IA.

Em outro estudo visando entender o uso de algoritmos de previsão de risco no contexto da justiça criminal nos EUA, uma proporção significativa dos 32 respondentes confiou excessivamente nessas ferramentas para tomar suas decisões. Determinamos o uso excessivo com base nos respondentes que relataram usar as ferramentas para determinar a duração ou severidade de uma sentença, seguir estritamente os resultados das ferramentas e aceitar como garantidos os resultados fornecidos pela ferramenta. Além de levantar questões legais e éticas fundamentais sobre a justiça, equidade e transparência de tais decisões judiciais automatizadas, esse resultado também aponta para uma abdicação da responsabilidade individual em favor dos algoritmos.

No geral, esses resultados iniciais confirmam o que foi observado em contextos semelhantes, ou seja, que os indivíduos tendem a perder seu senso de agência na presença de um sistema inteligente. Quando os indivíduos sentem menos controle — ou que algo mais está no controle — seu senso de responsabilidade também é diminuído.

À luz do exposto, devemos nos perguntar se o humano no loop, que é cada vez mais entendido como uma prática recomendada para o uso responsável da IA, é uma salvaguarda adequada. Em vez disso, a questão torna-se: como incentivamos os humanos a aceitar que têm responsabilidade proativa e a exercê-la?

Como observado no início deste artigo, os gestores tendem a exacerbar o problema ao encorajar a confiança na IA para aumentar a adoção. Esta mensagem é muitas vezes em termos que denigrem a cognição e a tomada de decisão humana como limitadas e tendenciosas em comparação com as recomendações da IA — apesar do fato de que todos os sistemas de IA necessariamente refletem os vieses humanos na seleção de dados, especificação e assim por diante. Esta posição assume que toda decisão da IA é correta e superior à decisão humana e convida os humanos a se desengajarem em favor da IA.

Para compensar essa tendência, recomendamos mudar o foco nas comunicações com os funcionários de confiar na IA para entender a IA, a fim de gerar confiança informada e condicional nos resultados dos sistemas e processos de IA. Os gestores precisam educar os usuários para entender os processos automatizados, os pontos de decisão e o potencial de erros ou danos da IA. Também é crucial que os usuários estejam cientes e compreendam as nuances dos casos extremos em que os sistemas de IA podem falhar e o risco de uma decisão automatizada ruim é maior.

Os gestores também precisam posicionar e preparar os funcionários para possuírem e exercerem seu senso de responsabilidade.

A Toyota modela isso de forma famosa ao capacitar qualquer pessoa no chão de fábrica a desligar a linha de produção se perceberem um problema. Isso incentivará os funcionários a questionar sistematicamente os sistemas e processos de IA e, portanto, manter seu senso de agência para evitar consequências prejudiciais para suas organizações.

Em última análise, uma cultura de responsabilidade — em vez de uma cultura de evitar a culpabilidade — sempre significará uma organização mais saudável e eticamente robusta. Será ainda mais importante fomentar essa cultura na era da IA, deixando espaços claros de possibilidade para a inteligência humana.

Caso contrário, a previsão de Roderick Seidenberg sobre tecnologias muito menos poderosas do que a IA atual pode se concretizar:

O funcionamento do sistema, auxiliado cada vez mais pela automação, age — certamente sem intenção maliciosa — como um canal de inteligência, pelo qual as contribuições individuais relativamente minúsculas de engenheiros, inventores e cientistas eventualmente criam um reservatório de conhecimento e procedimentos estabelecidos que nenhum indivíduo pode possivelmente abranger. Assim, o homem parece ter se superado e, de fato, em certo sentido, ele se superou. Paradoxalmente, no entanto, em relação ao sistema como um todo, cada indivíduo torna-se, por força, um beneficiário sem pensar — o destinatário inconsciente de um meio socialmente estabelecido. Por isso, falamos, não sem justificativa, de uma civilização de botões de pressão — um sistema de coisas elaborado pela inteligência para a eliminação progressiva da inteligência!

Fonte:

MIT Sloan Business Review USA – v65-4 – verão de 2024

Sobre o autor:

Ryad Titah é professor associado e presidente do Departamento Acadêmico de Tecnologias da Informação da HEC Montréal. A pesquisa em andamento descrita neste artigo está sendo conduzida com Zoubeir Tkiouat, Pierre-Majorique Léger, Nicolas Saunier, Philippe Doyon-Poulin, Sylvain Sénécal e Chaïma Merbouh.

Tradução fornecida pela OpenAI através do ChatGPT

A opinião do ChatGPT sobre o artigo acima.

Por se tratar de um assunto recente, do tipo que poucas publicações já abordaram (até junho de 2024), resolvemos perguntar para o ChatGPT qual é a opinião dele sobre o artigo acima, veja abaixo a sua resposta:

ChatGPT:

O artigo argumenta que a crescente confiança em sistemas de IA pode diminuir o senso de responsabilidade individual e senso de agência dos usuários. Vários estudos mostram que a confiança excessiva na IA pode levar as pessoas a abdicar de sua responsabilidade, o que é preocupante, especialmente em áreas como a direção de veículos autônomos e a justiça criminal.

Síntese adicional

O artigo destaca três tipos de responsabilidade definidos por Hans Jonas: legal, moral e senso de responsabilidade. Embora as práticas atuais de IA se concentrem principalmente nas responsabilidades legal e moral, o artigo enfatiza a importância do senso de responsabilidade. Este é definido como a capacidade de reflexão crítica e previsão das consequências das ações, tanto para si quanto para os outros.

- Principais pontos:

1. Confiança excessiva na IA:

Estudos mostram que a confiança na IA pode levar à diminuição da vigilância e da disposição de intervir em situações críticas.

2. Responsabilidade individual:

A pesquisa sugere que, mesmo que os indivíduos afirmem aceitar a responsabilidade, sua intenção de agir em situações problemáticas é reduzida quando confiam na IA.

3. Uso excessivo de ferramentas de previsão de risco:

No contexto da justiça criminal, há uma tendência preocupante de confiar excessivamente em algoritmos, levantando questões éticas e legais sobre justiça e equidade.

4. Cultura de Responsabilidade:

O artigo sugere que, em vez de encorajar a confiança cega na IA, as empresas devem promover a compreensão da IA e capacitar os funcionários a questionar e intervir quando necessário.

Conclusão diferente do artigo do MIT Sloan

Embora o artigo acima faça pontos válidos sobre os riscos da confiança excessiva na IA, também é importante reconhecer que a IA, quando usada corretamente, pode ser uma ferramenta poderosa para melhorar a eficiência e a precisão em várias áreas. O desafio, portanto, é encontrar um equilíbrio onde a IA seja usada como uma ferramenta auxiliar, mas onde os humanos ainda mantenham um papel ativo e responsável no processo de tomada de decisão.

Síntese Final

O artigo apresenta um argumento convincente sobre a necessidade de reavaliar como a IA é integrada em processos de decisão e a importância de manter um senso de responsabilidade individual. Para evitar os riscos associados à automação excessiva, é crucial que as organizações eduquem seus funcionários sobre as limitações da IA e os incentivem a manter uma vigilância crítica, garantindo assim que a tecnologia complemente, em vez de substituir, a inteligência e a responsabilidade humanas.

Fonte: ChatGPT – OpenAI

ChatGPT exibe sua definição sobre o termo senso de agência

O senso de agência do usuário refere-se à percepção que um indivíduo tem de ser o autor de suas próprias ações e decisões. Em outras palavras, é o sentimento de controle e responsabilidade que uma pessoa tem sobre suas próprias ações e os resultados dessas ações. Esse senso de agência é crucial para a autonomia e para a tomada de decisões informadas.

Componentes do Senso de Agência:

1. Controle Intencional: A percepção de que se tem o controle sobre iniciar e guiar suas ações de acordo com suas intenções e objetivos.

2. Responsabilidade Pessoal: O entendimento de que se é responsável pelas consequências de suas ações, sejam elas positivas ou negativas.

3. Autonomia: A sensação de que se é independente e capaz de tomar decisões livremente, sem coerção externa.

4. Reflexão Crítica: A capacidade de refletir sobre suas ações e decisões, considerando os possíveis impactos e consequências.

Importância do Senso de Agência:

– Motivação e Engajamento: Quando os indivíduos sentem que têm controle sobre suas ações, eles tendem a estar mais motivados e engajados em suas atividades.

– Responsabilidade e Ética: Um forte senso de agência está relacionado a um comportamento ético e responsável, já que as pessoas se sentem mais compelidas a considerar as implicações de suas ações.

– Tomada de Decisão Informada: A sensação de controle permite que as pessoas façam escolhas mais informadas e refletidas.

Impacto da IA no Senso de Agência:

Conforme discutido no artigo, a introdução de sistemas de IA pode influenciar negativamente o senso de agência dos usuários de várias maneiras:

– Confiança Excessiva na IA: Quando os usuários confiam demasiadamente nas recomendações da IA, podem sentir que a máquina está no controle, diminuindo sua própria percepção de agência.

– Diminuição da Vigilância: A confiança na IA pode levar à complacência, onde os usuários não se sentem responsáveis por monitorar ou questionar as decisões automatizadas.

– Abdicação de Responsabilidade: Os usuários podem começar a delegar completamente a responsabilidade para os sistemas de IA, acreditando que a máquina é mais capaz de tomar decisões corretas.

Conclusão

O senso de agência é um aspecto fundamental da experiência humana, influenciando a motivação, a responsabilidade e a tomada de decisões. Com a crescente integração de sistemas de IA, é essencial encontrar maneiras de preservar e fortalecer o senso de agência dos usuários, garantindo que eles se sintam no controle e responsáveis por suas ações, mesmo em um ambiente altamente automatizado.

Fonte da definição de senso de agência: ChatGPT – OpenAI